Hallo Michael!

Das, was Fritz da macht, könnte durchaus auch ein nützlicher Ansatz sein (es gibt mittlerweile ja auch einen SF, der MC- Suche betreibt von "Ipman" im Immortal, leider noch ohne Compiles und es scheinen die Versuche dazu auch noch nicht wirklich zu funktionieren).

Ich frage mich aber immer, was eigentlich der prinzipielle Unteschied zwischem dem Superüberdrüber- Lernen von DeepMind ist und, in Hinblick auf Schach, dem, was wir unter Hash- Lernen verstehen.

Ich fürchte, man wird es mir auch nicht so erklären können, dass ich es verstehe, vor allem, weil ja das Lernen von DeepMind auch die Programmierer, die das erfunden haben, nicht mehr verstehen (wollen, nur kein Human Imput mehr, sonst wär's ja nicht so toll).

Bevor ich wieder ins Polemisieren komme, im Ernst:

Die ganzen YouTube- Meister, die da jetzt die wenigen A0-SF- Partien wieder- und wiederkäuen und sich und einander immer wieder vor den selben Super- Über- Drüberzügen auf die jeweiligen Bäuche in den Staub werfen (möchte mal sehen, welcher dieser vielen Analysanten das ohne terrestrische Engine- Unterstützung überhaupt selbst durchschaute, was da am Brett abgelaufen ist), würden vermutlich einfach nicht so werbewirksame Video- Auftritte haben, wenn das einfach nur ein länger rechnender Houdini im Taktik- Modus gegen SF ohne Buch mit fixierter 1'/Zug TC gezaubert hätte, und vielleicht auch noch das Never Cleard Hash aktiveriert und das Ganze wäre buchlos gelaufen.

SF immer mit leerem Hash neu gesartet, H6 mit immer wieder zwischen den Patien abgespeichertem und neu geladenem Hash und ein neues Buch wäre ihm dabei mit Buchlernen ein vom GUI auch ständig aktualiserte worden. Dazu noch ein praktisch beliebig großer Hardware- Vorteil, eigenes Zeitmanagement und vielleicht eine 5fache Bedenkzeit, die bei nicht mehr hilfreichem Hardware- Vorteil immer noch hilft.

Hat jemand, der derlei Experimente auch schon hin und wieder gemacht hat, mit Settings, mit Engines mit höherem Contempt, mit all diesen kleinen Tricks, mit denen Fernschachspieler schon lange arbeiten, um einfach zu Ideen zu kommen, nicht auch das sichere Gefühl, es hätte kein 100 Partien gebraucht, um 10 herzeigbare zu bekommen mit erstaunlichen Engine- Zügen, gegen die der kastrierte SF- Gegner einfach zu Fehlern auf hohem Niveau gezwungen wäre?

Und nicht alle waren auf hohem Niveau, das 49...Tf8 ?? aus der dritten Partie war einfach ein Hardware- Software- Armutszeugnis, ich vermute mal, wenn nicht Herr- Professor Althöfer mit seinem Vorschlag, das könnte auch schlicht ein Mouseslip eines manuellen Bedieners gewesen sein, (...Kf8 statt ...Tf8?? und die Welt schaut schon wieder ganz anders aus, falsche Figur angeklickt, hmh?) ansonsten hat da SF vielleicht einfach in Erkenntnis der bereits an der Grenze der haltbaren Stellung im Fail Low die nächstschlechteste Iteration auszuspielen von der Minutengrenze gezwungen worden sein.

Oder es wären die Superüberdrüberzüge im Fernschach aufs Brett gekommen, kein Hahn würde danach krähen, sag ich mal.

Forward- Backward heißt doch da schon ewig lang das einzige Zauberwort, das es brauchte und braucht, um die "übermenschlichen" Züge, die die Engines halt nicht eh schon alle sofort aus dem Ärmel schütteln, sondern für die sie ein bisschen länger brauchen, vielleicht ein bisschen Parameter- Tuning oder nur schlicht und einfach durch Eingeben der nächsten paar Züge bis zum Kippen der Eval, und schon ist ihnen mit ein bisschen größerem Hash, das Matt in 45 oder das 0.00 des 50- Züge- Horizonts im Hash rückwärts fast beliebig lange Zugstrecken behaltbar.

Wenn eine Engine, die wir heute schon haben, und bis vor Kurzem doch auch gerade dafür noch recht lieb gehabt haben, Hardware, Zeit und Hash genug hat, automatisiert Forward Backward zu spielen (Fritz Stellungsanalyse, cb Tiefe Analyse, Aquarium IdEA...), war das doch bis vor Kurzem auch noch ein recht approbates Mittel, Zugzwang, Festungen

und Eröffnungstellungen besser als im Single Variant Mode im Standrechnen oder gar im Schnellschach- Autoplay "finden" zu lassen.

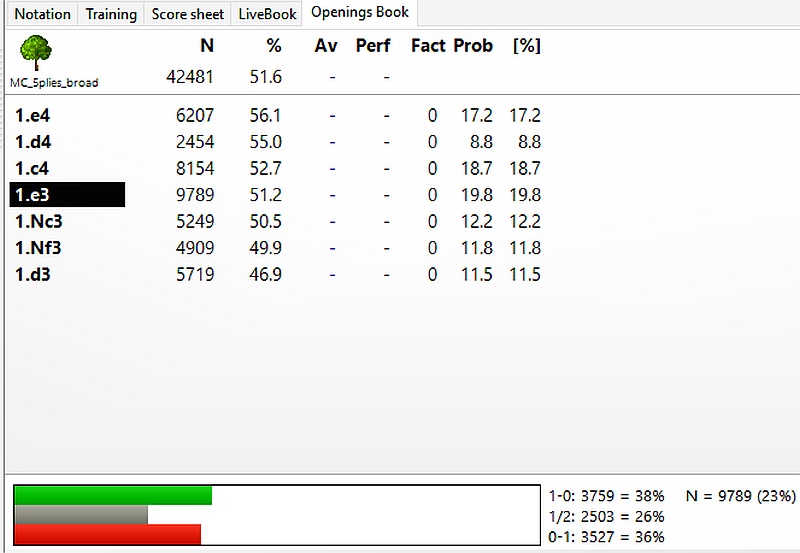

Könnte man aus dem A0- Debakel nicht auch mal einfach die Folgerung ziehen, dass Hash- (und Buch-) Lernen (in seinen verschiedenen Formen, SF- PA z.B., Lerndateien im Allgemeinen, automatisch vom GUI editiertes Buch, übrigens das, was die Fritz- MC- Analyse tut, sie erstellt so ein Buch, die Stellungsanalyse ebenso...) sei's auch ohne Monster- Hardware (aber natürlich gerade auf solcher) auch für die terrestrischen Blechis ein Ansatz und ein Way to Go war und ist?

Macht der (hoffentlich auch wirklich irgendwann dem User zugängliche) Sirius- Cerebellum- Algorithmus etwas soo wesentlich Anderes als Stellungslernen, ist das nicht auch AI im modernen Sinn?

Ich will ja gar nicht davon anfangen, dass jeder Fernschachspieler, der mit ein bisschen mit EDV- Unterstützung arbeitet, nichts anderes macht als gegen bestimmte Gegner bestimmte Datenbankrecherchen, die mit FW-BW interaktiv zu beackern und zu ordnen und die zu einem eigenen Buch oder Baum für die jeweilige einzelne Partie abzuspeichern?

Sind alle diese Arten von Stellungslernen mit oder ohne menschlichen Input wirklich soo viel anders als das ganz und gar neue AI- Lernen von DeepMind?

Und wenn ja, warum lässt Google dann nicht gleich gegen einen SF spielen, der, wenn er schon ohne Buch antreten muss, wenigstens nicht zwischen den Partien immer wieder den Hash löscht, A0 hatte ja diesen Nachteil auch nicht.

Ich kann mir nicht helfen, das was wir vom DeepMind- Lernen zum Thema Schach derzeit wissen, befriedigt mich einfach in keiner Weise, und das liegt nicht nur an meinen fehlenden Programmierkenntnissen.

Weder als Schachspieler noch als Computerschachspieler, und durch Ehrfurcht allein werden wir auch nicht mehr dazu von Google erfahren, schätze ich halt mal.

Was hätten die Google- Götter davon, ihr "Wissen" wirklich mit der Programmierer- und Userschaft zu teilen?

Werbung geht anders.

das ist Teil der Funktion. Man kann nur eine M.C.-fähige Engine auswählen, und es liefen vier Instanzen der F15-Engine gleichzeitig. Außer Rybka 4+ bzw. F15 und wie ich annehme F16, ist mir keine Engine bekannt welche diese Funktion unterstützt. Mit Deep Fritz 13 geht es beispielsweise nicht. - Mit +7 meine ich daß Rybka ja intern seit jeher mehr Iterationen macht als im Output angegeben. Die Rede war von +2 bei Rybka 1 und 2, und möglicherweise +3...4 später. Das wurde beim Reverse Engineering entdeckt.

das ist Teil der Funktion. Man kann nur eine M.C.-fähige Engine auswählen, und es liefen vier Instanzen der F15-Engine gleichzeitig. Außer Rybka 4+ bzw. F15 und wie ich annehme F16, ist mir keine Engine bekannt welche diese Funktion unterstützt. Mit Deep Fritz 13 geht es beispielsweise nicht. - Mit +7 meine ich daß Rybka ja intern seit jeher mehr Iterationen macht als im Output angegeben. Die Rede war von +2 bei Rybka 1 und 2, und möglicherweise +3...4 später. Das wurde beim Reverse Engineering entdeckt.

) beschränkbar, damit er auch in den Arbeitsspeicher passt, aber auch nicht zu sparsam, "Merge" klappt auch automatisch, die Grundanforderungen halt.

) beschränkbar, damit er auch in den Arbeitsspeicher passt, aber auch nicht zu sparsam, "Merge" klappt auch automatisch, die Grundanforderungen halt.

) an einer Maschine zu erkennen, liegt nahe.

) an einer Maschine zu erkennen, liegt nahe.